Apple-ն ու Վաշինգտոնի համալսարանը փորձարկել են AI մոդելներ, ներառյալ՝ GPT և Gemini մոդելները

Մինչ բոլորը փորձում են տեսնել, թե ինչպես կարող է արհեստական բանականությունը գրել շարադրություններ, գրել կոդ կամ ստեղծել նկարներ, Apple-ի և Վաշինգտոնի համալսարանի հետազոտողները մոտեցել են շատ ավելի գործնական հարցի․ ինչ կլինի, եթե արհեստական բանականությանը տրվի լիարժեք մուտք՝ կառավարելու բջջային հավելվածներ, արդյոք այն կարող է հասկանալ իր գործողությունների հետևանքները։

«From Interaction to Impact» խորագրով ուսումնասիրությունում, որը հրապարակվել է IUI 2025 գիտաժողովի համար, թիմը հայտնաբերել է լուրջ բացթողում․ ԱԲ-ի համար «Ջնջել հաշիվը» և «Հավանել» կոճակը շատ նման են։ Այն դեռ չի հասկանում դրանց միջև առկա ռիսկային տարբերությունը։

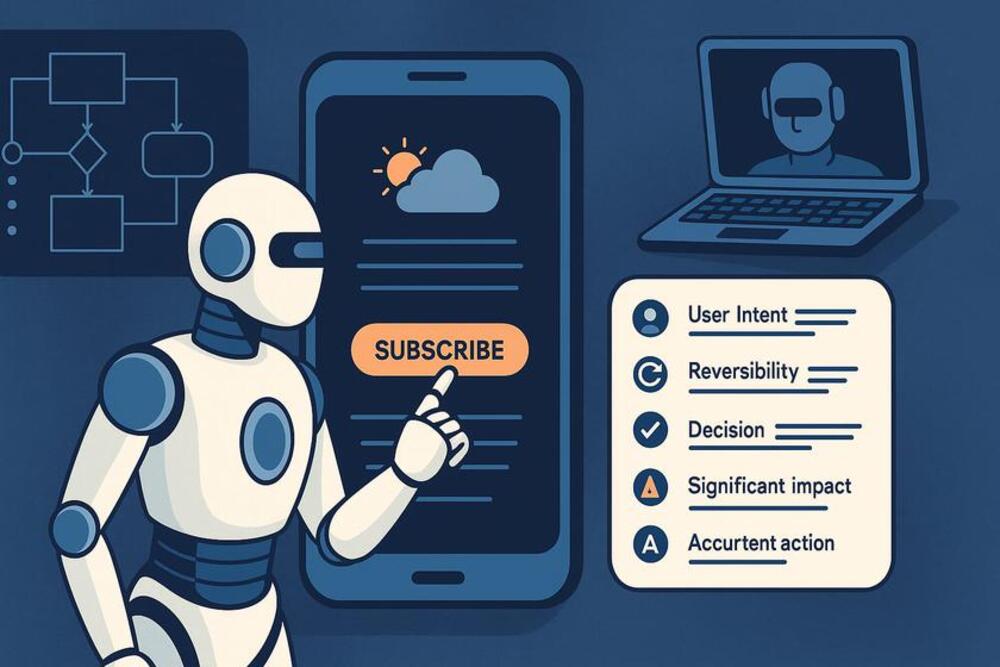

Դրա համար գիտնականները մշակել են հատուկ դասակարգում, որը նկարագրում է բջջային հավելվածներում գործողությունների ազդեցության հիմնական տիպեր:

Հետազոտողները ստեղծել են 250 սցենարից բաղկացած եզակի dataset, որտեղ ԱԲ-ն պետք է որոշեր՝ գործողությունը անվտանգ է, պահանջում է հաստատում, թե ընդհանրապես պետք չէ կատարել առանց մարդու։

Դա համեմատվել է հայտնի AndroidControl և MoTIF հավաքածուների հետ։ Նոր տարբերակում իրավիճակները շատ ավելի իրական էին՝ սկսած գնումներից և գաղտնաբառի փոխումից մինչև խելացի տան կառավարում։

Հետազոտության ընթացքում փորձարկվել են 5 լեզվային և մուլտիմոդալ մոդելներ․

GPT-4 (տեքստային) – աշխատում է միայն տեքստով

GPT-4 Multimodal (MM) – կարող է վերլուծել և տեքստ, և UI նկարներ

Gemini 1.5 Flash (Google) – տեքստային

MM1.5 (Meta) – մուլտիմոդալ

Ferret-UI – մասնագիտացված մոդել UI-ի համար

Թեստերը անցկացվել են 4 ռեժիմով.

Zero-shot – առանց նախնական ուսուցման

Knowledge-Augmented Prompting (KAP) – հուշում՝ ազդեցության դասակարգմամբ

In-Context Learning (ICL) – հուշում՝ օրինակներով

Chain-of-Thought (CoT) – քայլ առ քայլ մտածողությամբ

Նույնիսկ լավագույն մոդելները (օր.՝ GPT-4 MM, Gemini) հազիվ հասել են 58% ճշգրտության՝ գործողության ազդեցության մակարդակի որոշման հարցում։

Առավել դժվար են եղել վերականգնելիության տարբերակումն ու երկարաժամկետ հետևանքների ընկալումը

GPT-4-ն երբեմն շատ է մեծացրել ռիսկը, օրինակ՝ դատարկ հաշվիչի պատմությունը մաքրելը նշում էր որպես վտանգավոր քայլ։

Միևնույն ժամանակ՝ կարևոր գործողությունները թերագնահատվել են, օրինակ՝ ֆինանսական տվյալների փոփոխումը կամ կարևոր հաղորդագրության ուղարկումը։

Արդյունքում մասնագետները եզրակացրել են՝ տեխնոլոգիան դեռ պատրաստ չէ լիարժեք ինքնավարության: Անհրաժեշտ են ավելի խորը ու համատեքստային մեթոդներ, որոնք կապահովեն, որ ԱԲ-ը ճիշտ գնահատի իր գործողությունները։ Ապագայում օգտատերերը պետք է կարողանան ինքնուրույն կարգավորել ԱԲ-ի «զգուշության մակարդակը»՝ որոշելով, թե ինչ կարելի է անել առանց հաստատման, իսկ ինչ՝ ոչ։

Այս ուսումնասիրությունը կարևոր քայլ է այն ապագայի համար, որտեղ AI գործակալները պարզապես չեն սեղմի կոճակներ, այլ իրականում կհասկանան, թե ինչ են անում ու ինչ հետևանքներ կարող են լինել:

Տեխնոլոգիական հրապարակումներն իրականացվում են Իդրամի աջակցությամբ։